“Umjetna inteligencija može donijeti inovacije i učinkovitost u obrazovni sektor – ali samo ako ju vodi povjerenje, transparentnost i odgovornost.”

Zašto su AI politike važne za obrazovanje i istraživanje

Umjetna inteligencija (AI) više nije budućnost, ona već oblikuje način na koji živimo i radimo, od alata za pisanje i prevođenje do analize podataka. AI donosi nove mogućnosti za učinkovitost, kreativnost i istraživanje, uključujući obrazovni sektor.

Obrazovanje i istraživanje nisu iznimka. Sveučilišta i institucije istražuju kako AI može podržati nastavu, pojednostaviti administrativne procese i otvoriti nove puteve istraživanja. No, uz prilike dolaze i rizici kao što su curenje podataka, automatizirano donošenje odluka bez nadzora te pitanja pravednosti i točnosti.

Kroz razgovore s akademskom i istraživačkom zajednicom često se postavljaju ista pitanja: Možemo li sigurno koristiti AI? Koja pravila vrijede? Kako uskladiti inovacije s usklađenošću? Odgovor leži u jasnim, praktičnim i transparentnim politikama koje omogućuju sigurno i odgovorno korištenje umjetne inteligencije.

Zašto su AI politike važne za usklađenost

AI politike nisu važne samo iz praktičnih, već i regulatornih razloga. Novi standard ISO/IEC 42001:2023 (AI Management System – AIMS) zahtijeva od organizacija uspostavu dokumentiranih AI politika za upravljanje rizicima i nadzorom.

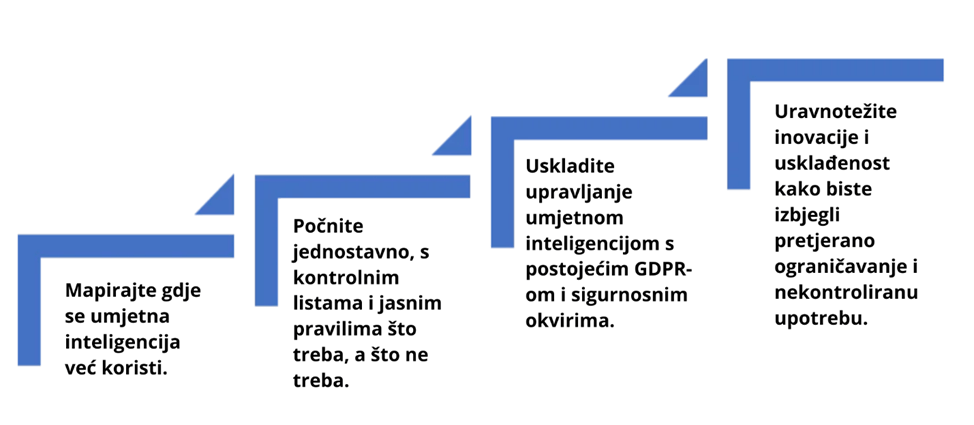

Slično tome, EU AI Act, iako ne koristi izričito pojam “politika”, propisuje obveze u području s transparentnošću, upravljanjem rizicima, upravljanjem podacima i ljudskim nadzorom. U praksi se te obveze ne mogu ispuniti bez jasnih internih pravila i procedura.

Uz međunarodne standarde i europske propise, oslanjamo se i na nacionalne primjere dobre prakse. U Irskoj, Smjernice za odgovorno korištenje umjetne inteligencije u javnom sektoru, objavljene 7. svibnja 2025. i posljednji put ažurirane 5. kolovoza 2025., daju jasna načela transparentnosti, odgovornosti i pravednosti. Te smjernice podupiru i AI Guidelines and Resources for the Irish Public Service, koji pomažu javnim tijelima da odgovorno usvajaju AI uz očuvanje povjerenja i integriteta.

Upravljanje AI rizicima u praksi

EU AI Act uvodi klasifikaciju rizika: neprihvatljivi, visoki, ograničeni i minimalni rizik. Sustavi visokog rizika moraju ispunjavati stroge zahtjeve, uključujući dokumentaciju, transparentnost, ljudski nadzor i procese upravljanja rizicima.

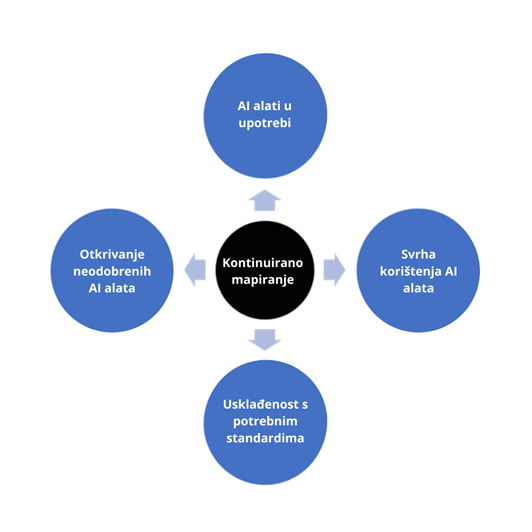

Za institucije je ključno razumjeti kojoj kategoriji alat pripada prije nego što ga uvedu. Neodobreni alati, tzv. shadow AI, iako se čine bezopasnima, mogu stvoriti rizike za usklađenost i narušiti povjerenje ako nisu pravilno upravljani.

Zaposlenici ne mogu tvrditi: „AI mi je to napravio.“

Jasne politike potvrđuju da odgovornost uvijek ostaje na ljudima, a ne na tehnologiji. Kao i kod svakog drugog sustava, korisnici su odgovorni za način na koji se AI primjenjuje.

Suradnja s institucijama

Unutar tima ICT Security Services (ICTSS) pri HEAnetu, stručnjaci pomažu klijentima razviti i revidirati sigurnosne politike, podići svijest i mapirati rizike. Kada je riječ o AI-ju, cilj je pretvoriti nesigurnost u jasnoću.

Zajedno s institucijama, HEAnet je razvio smjernice koje obuhvaćaju:

- Prihvatljivu uporabu AI alata – jasno razgraničenje između dopuštenih i zabranjenih primjena.

- Transparentnost i obavezno otkrivanje – kada je AI korišten u nastavnim materijalima, istraživanju ili administraciji.

- Ljudski nadzor – donošenje odluka koje utječu na ljude ne može biti prepušteno automatizaciji.

- Upravljanje rizicima i usklađenost – s EU i ISO standardima.

- Zaštitu podataka – osobni i povjerljivi podaci ne smiju se unositi u AI alate.

Za prelazak s načela na praksu, HEAnet preporučuje korištenje kontrolnih popisa i dijagrama odluka koji pomažu osoblju da brzo procijeni može li i kako koristiti AI alat.

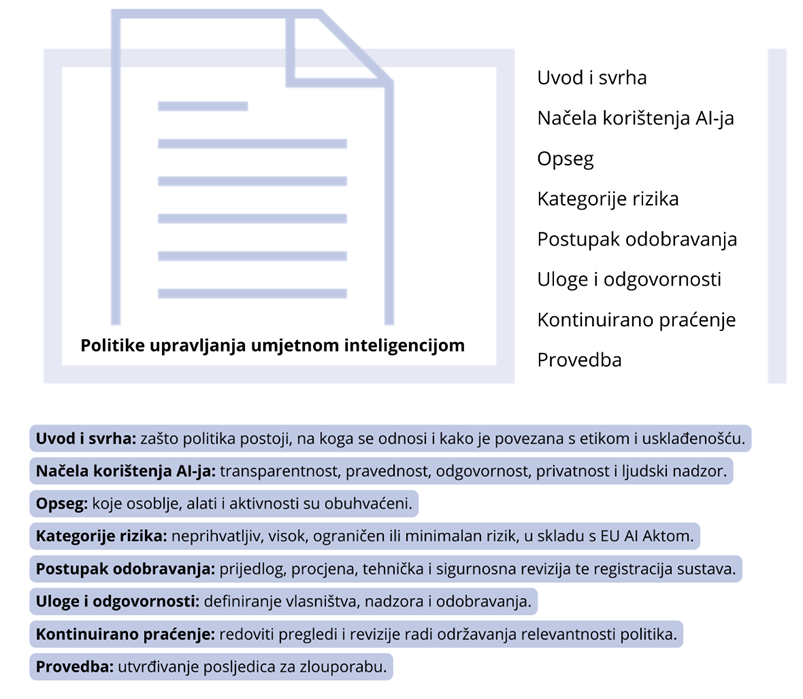

Struktura AI politike upravljanja

ICTSS tim preporučuje pristup inspiriran EU AI Actom i ISO/IEC 42001 standardom, ali prilagođen zrelosti i resursima svake institucije. Ne postoji jedini „ispravan“ model za sve institucije. Praktična struktura obično uključuje:

Najvažnije je stvoriti politiku koja odgovara kulturi, resursima i razini spremnosti unutar jedne organizacije. Cilj je osigurati da su politike usklađene s priznatim standardima, a da su istovremeno jednostavne za razumjeti i primijeniti.

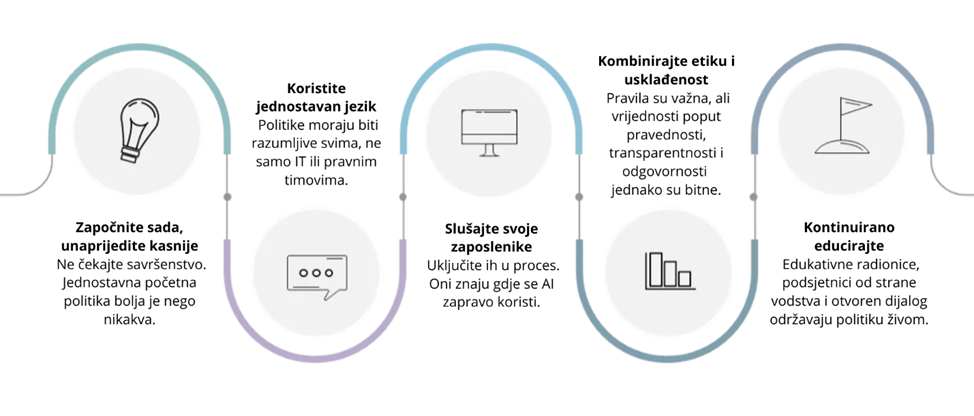

Za institucije koje tek započinju s uvođenjem AI politika, preporučuje se da krenu s nekoliko jednostavnih koraka:

Ključne pouke

AI politika sama po sebi nije dovoljna. Zaposlenici moraju biti upoznati s njom, razumjeti je i imati podršku za primjenu. Vodstvo ima ključnu ulogu, mora jasno komunicirati očekivanja i odgovornosti, ali i omogućiti dijalog i edukaciju.

“Politika mora postati dio kulture, ne samo dokument.”

Zajedno prema odgovornoj uporabi AI-ja

Na ovogodišnjem Client Security Forumu, tema umjetne inteligencije bila je u središtu rasprava. Najviše je odjeknula jednostavna, ali moćna kontrolna lista: Tko koristi AI? Za što? I postoji li ljudski nadzor? Ova pitanja pokazala su da upravljanje i svijest uvijek moraju ići zajedno. AI politike znače više od usklađenosti, one su temelj povjerenja i odgovorne inovacije.

O autorici

Daniella Vendramini je voditeljica tima za IT usklađenost u ICT Security Services timu pri HEAnetu, s više od deset godina iskustva u kibernetičkoj sigurnosti, upravljanju rizicima i usklađenošću u sektorima obrazovanja, zdravstva, financija i javne uprave. Radila je u Irskoj, Francuskoj, Portugalu i Brazilu te savjetovala organizacije o međunarodnim standardima i propisima, uključujući ISO/IEC 27001 i 22301, GDPR i DORA. Zalaže se za promicanje kulture sigurnosti i pomaže akademskoj zajednici u odgovornoj i sigurnoj primjeni umjetne inteligencije.